ollama是什么?

Ollama 是一个强大的框架,设计用于在 Docker 容器中部署 LLM。Ollama 的主要功能是在 Docker 容器内部署和管理 LLM 的促进者,它使该过程变得非常简单。它帮助用户快速在本地运行大模型,通过简单的安装指令,可以让用户执行一条命令就在本地运行开源大型语言模型,例如 Llama 2。

Ollama 将模型权重、配置和数据捆绑到一个包中,定义成 Modelfile。它优化了设置和配置细节,包括 GPU 使用情况。

安装 ollama

ollama极大的简化了安装的过程,并提供了多种选择。

支持的平台包括:Mac和Linux,并提供了docker 镜像。

Mac:

如果你使用的是Mac,那么你可以直接下载安装包,地址如下:

curl https://ollama.ai/install.sh | sh 直接执行命令,可以完成默认安装。

使用 ollama

笔者以Mac为例,安装完成后打开ollama的应用,简单的点击确认后,就已经启动了ollama的服务器。

下一步我们启动一个Llama2,只需要执行:

ollama run llama2

之后会自动去pull Llama2的模型,并运行,确实非常的便捷。另外还支持将Ollama作为服务提供到网络环境中,在 macOS 中:

OLLAMA_HOST=0.0.0.0:11434 ollama serve

除了Llama2以外 Ollama 还支持其他的开原模型

另外还需要注意一下文档中的运行资源说明:

3B模型需要8G内存,7B模型需要16G内存,13B模型需要32G内存。

除了简单的启动模型外,Ollama 可以通过编写 Modelfile 来导入更多的自定义模型,具体的使用方法和配置请自行查阅文档。

Ollama具备灵活的扩展性,它支持和很多工具集成,除了命令行的使用方式,可以通过配合UI界面,简单快速的打造一个类ChatGPT应用。笔者也计划抽空写一期专门的教程,来介绍一个如果快速通过Ollama搭建一个仿ChatGPT。

项目特点

- 开源:很显然这是首要特点,开源推动者项目的持续发展

- 开箱即用:一条命令的方式,简化了大量的工作,降低了门槛。

- 可扩展:可以和很多工具进行集成使用,有更多的玩法

- 轻量化:不需要太多的资源,Mac就能跑

项目信息

- 项目名称:Ollama

- 官方网站:https://ollama.ai/

- GitHub 链接:https://github.com/jmorganca/ollama

- Star 数:22K+

#卸载ollama

sudo systemctl stop ollama sudo systemctl disable ollama sudo rm /etc/systemd/system/ollama.service

su root cd / 然后会进入系统的根目录

curl https://ollama.ai/install.sh | sh 官方安装命令 安装成功后,需要启动下Ollama服务,最好是后台运行; nohup ollama serve &

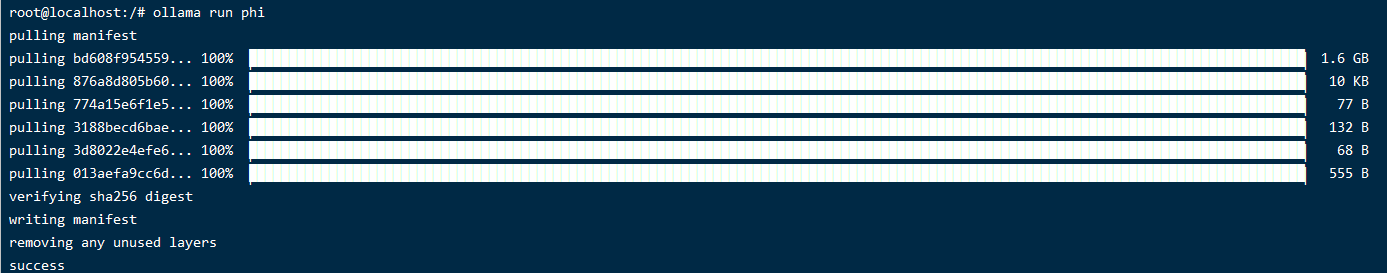

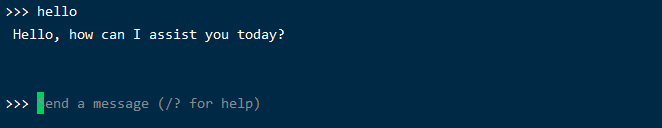

ollama run phi

curl http://localhost:11434/api/chat -d '{

"model": "phi",

"messages": [

{ "role": "user", "content": "why is the sky blue?" }

]

}'

Docker部署,解决无法0.0.0.0启动服务的问题

CPU: docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama 模型默认路径:/var/lib/docker/volumes/ollama

#GPU启动 docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama #如果根目录硬盘比较小,可以更改下模型的下载路径 docker run -d --gpus=all -v /home/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

Centos7安装显卡驱动

1、先去Nvidia下载显卡对应的驱动,下面的地址可以下载历史的驱动 https://www.nvidia.cn/geforce/drivers/?share_token=d32b8dba-c64a-4ec3-905c-df4c4dc5fa2d 2、下载后,把文件上传到centos7root目录,然后./文件名 执行安装即可: 3、nvidia-smi 执行如果显是显卡和GPU信息,就说明驱动安装成功啦!

安装配套的系统软件

1、配置存储库

curl -s -L https://nvidia.github.io/libnvidia-container/stable/rpm/nvidia-container-toolkit.repo \

| sudo tee /etc/yum.repos.d/nvidia-container-toolkit.repo

2、安装英伟达工具包

sudo yum install -y nvidia-container-toolkit

3、配置docker使用英伟达驱动

sudo nvidia-ctk runtime configure --runtime=docker

sudo systemctl restart docker

4、配置好以后启动docekr即可

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

#如果根目录硬盘比较小,可以更改下模型的下载路径

docker run -d --gpus=all -v /home/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

参考链接:https://blog.csdn.net/qq_41240287/article/details/127213984

通过Docker调试大模型

docker exec -it ollama ollama run llama2

通过API实现调用 逐字回复内容

curl -X POST http://ip:11434/api/generate -d '{

"model": "llama2",

"prompt":"hello"

}'通过API实现调用 答复完一起取到结果

curl http://192.168.197.200:11434/api/generate -d '{

"model": "llama2",

"prompt": "1+1=?",

"raw": true,

"stream": false

}'

Ollama其他命令

systemctl stop ollama.service #停止ollama systemctl disable ollama.service #禁用ollama systemctl status ollama.service #查看ollama状态

赞

赞

打赏

打赏  生成海报

生成海报

发表回复

评论列表(10条)

Ollama安装简便,运行流畅,但需注意内存需求。模型切换方便,API调用也易上手。总体体验优秀!

Ollama安装方便,运行速度快,但需注意内存需求。模型切换便捷,API调用也简单易用。

Ollama安装简单,运行快速,但资源占用较高,模型选择丰富。

Ollama安装简便,运行流畅,但模型资源占用较大。

Ollama安装简单,运行流畅,但模型体积较大,内存占用很高。

Ollama安装方便,运行流畅,但需注意内存需求。模型加载速度快,交互体验佳。

Ollama安装简便,运行流畅,但模型资源占用较大。

Ollama安装简单,运行快速,但资源消耗较大,需谨慎选择模型。

Ollama安装简单,运行流畅,但需要足够内存! 模型切换方便,API调用好用。

Ollama安装简便,运行流畅,但模型体积较大,需充足内存。 API调用方便,值得推荐!

Ollama安装简便,运行流畅,但资源消耗较大,需注意内存配置。模型切换方便,API调用也易上手。

Ollama安装简单,运行流畅,但模型加载速度受限于硬件。

Ollama安装简便,运行流畅,但模型下载速度受网络影响较大。

Ollama安装简易,运行流畅,但模型资源消耗较大。 值得推荐!

Ollama安装简便,运行流畅,但需注意内存占用。 模型切换方便,API调用也易上手。